Im Rahmen des London Design Festivals nahm VA-PEPR am Digital Design Weekend 23 teil

Die interaktive Installation des VA-PEPR-Projekts (genannt: Voice Matters) wurde während des Digital Design Weekend 23 im Victoria and Albert Museum in London im Rahmen des London Design Festival 🎉 👏 ausgestellt.

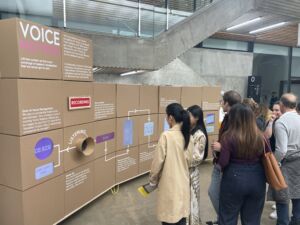

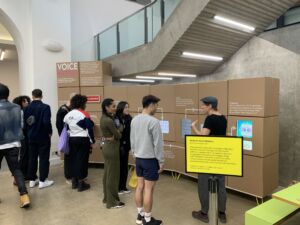

Das Team präsentierte „Voice Matters“, eine Installation, die zum Nachdenken anregt und die faszinierende Schnittmenge von KI und menschlicher Interaktion erforscht. Die Installation befasste sich mit der Fähigkeit der KI, unsere Gespräche zu hören, zu verstehen und zu interpretieren. 🤖 Teilnehmer aller Altersgruppen erlebten aus erster Hand, wie viel von unseren täglichen Gesprächen von den uns umgebenden intelligenten Geräten verstanden und zusammengefasst werden kann.

Herzlichen Glückwunsch an Michael Shorter, Jon Rogers, Melanie Rickenmann, Aurelio Todisco, Aysun Aytaç, Sabine Junginger und Edith Maier!

Die Installation wird demnächst an der Hochschule Luzern – Design & Kunst (HSLU D&K) zu sehen sein. Stay tuned!

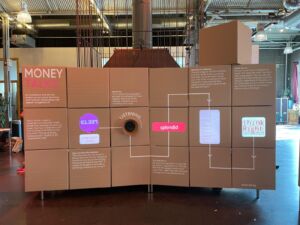

Wie funktioniert VOICE MATTERS?

Die Mikrofone Die Mikrofone in Voice Matters ist mit einer Reihe von Raspberry Pis verbunden und läuft mit Microsofts Cloud-basierter KI, Azure. Gemeinsam hören sie ständig zu, verstehen und übersetzen alles, was gehört wird. Diese Daten werden dann in ein ständig wachsendes Textdokument eingefügt, das dann auf verschiedene Weise analysiert wird. Dieses wird auf den 7 Bildschirmen von Voice Matters angezeigt.

Bildschirm 1: Kosten der Spracherkennung Auf diesem Bildschirm werden die Kosten für den Betrieb von Voice Matters angezeigt, zu denen auch der Echtzeit-Dienst „Sprache zu Text“ von Microsoft und der Chat-GPT-Dienst von OpenAI gehören. Wir bezahlen dafür, dass wir unserer Umgebung ständig zuhören. Wir wollten, dass die Betrachter darüber nachdenken, ob sie dies gerne bezahlen würden. Oder sollte die Spende ihrer Daten an Technologieunternehmen ausreichen?

Bildschirm 2: Das letzte Wort Dieser Bildschirm zeigt das letzte Wort an, das Microsofts Sprache-zu-Text-Dienst glaubt, gehört zu haben. So kann der Betrachter sehen, wie Akzente verstanden werden, aber auch, wie empfindlich die Hardware ist.

Bildschirm 3: Vertrauen in die Maschine Die Technologie ist nicht zu 100 % von ihrer eigenen Fähigkeit überzeugt, genau zu hören. Dieser Bildschirm hebt die Klappe zu dieser Blackbox-Technologie und ermöglicht es dem Betrachter zu sehen, wie sicher die KI bei allen Wörtern war, die sie gehört hat. Noch interessanter sind die Wörter, die sie nicht gehört hat: die Wörter, bei denen maschinelles Lernen zum Ausfüllen von Lücken verwendet wird.

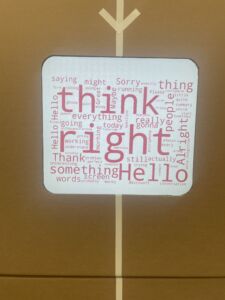

Bildschirm 4: WordCloud Auf diesem Bildschirm wird eine WordCloud mit dem angezeigt, was die KI gehört hat. Je größer das Wort ist, desto häufiger wurde es gehört.

Bildschirm 5: Themen Hier nutzen wir die Möglichkeiten von ChatGPT, um die Sprachdaten zu analysieren und eine aussagekräftige Zusammenfassung zu erstellen. Dieser Bildschirm zeigt das Ergebnis der Aufforderung an ChatGPT, die fünf wichtigsten Themen in der Reihenfolge ihrer Wichtigkeit zu generieren.

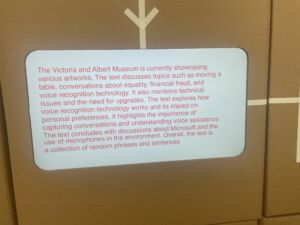

Bildschirm 6: Zusammenfassung Dieser Bildschirm zeigt die Ausgabe der Aufforderung an ChatGPT an, eine Zusammenfassung mit 75 Wörtern aus den Sprachdaten zu erstellen.

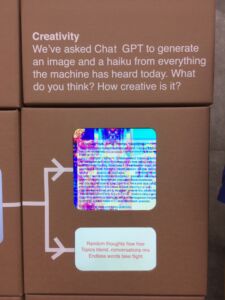

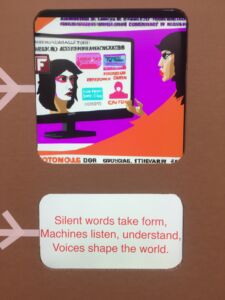

Bildschirm 7: Kreativität Wie kreativ ist ChatGPT? Dieser Bildschirm erzeugt ein Bild und ein Haiku aus allem, was die Maschine gehört hat.