AI vor Gericht: Schuldig oder nicht?

Rechtliche und ethische Herausforderungen der zunehmenden Verbreitung von Artificial Intelligence.

Es ist ein Fall, der auch hierzulande für viel Aufregung gesorgt hat: Im Mai 2016 hat sich im US-Bundesstaat Florida erstmals eine Kollision mit einem hochautomatisierten Auto ereignet. Der Insasse des Fahrzeugs der Marke Tesla kam bei der Kollision mit einem Lastwagen ums Leben. Nun stellt sich die Frage, wer bei solchen Unfällen die Verantwortung trägt (Henkel, 2016).

Ein weiteres Beispiel für das Versagen von derartigen halb- bzw. hochautomatisierten Systemen ist der tödliche Unfall mit einem Fahrzeug der Firma Uber im März 2018. Das Auto kollidierte zu später Stunde mit einer Fahrradfahrerin, welche die Strasse abseits eines Fussgängerstreifens überquerte. Obwohl das Auto selbstfahrend unterwegs war, sass zum Zeitpunkt des Unfalls eine Frau hinter dem Steuer. Diese sogenannte Sicherheitsfahrerin war jedoch zu wenig aufmerksam und realisierte zu spät, dass das Fahrzeug die Fahrradfahrerin nicht als Hindernis einstufte (Hebermehl & Stegmaier, 2018).

Dieser Blogtext schildert anhand von Beispielen, in welchen Situationen Menschen mit Artificial Intelligence (AI) in Kontakt kommen und wer im Schadensfalle dafür haften muss oder sollte. Ein Professor für Maschinenethik und ein Experte für Recht im digitalen Zeitalter äussern sich zu möglichen Haftungsmodellen zur Schuldfrage sowie ethischen wie auch rechtlichen Herausforderungen im Zusammenhang mit der zunehmenden Verbreitung artifizieller Systeme. Ziel des Artikels ist, den LeserInnen verschiedene Denkanstösse zu bieten und etwas zur Sensibilisierung dieses heutzutage omnipräsenten Themas beizutragen.

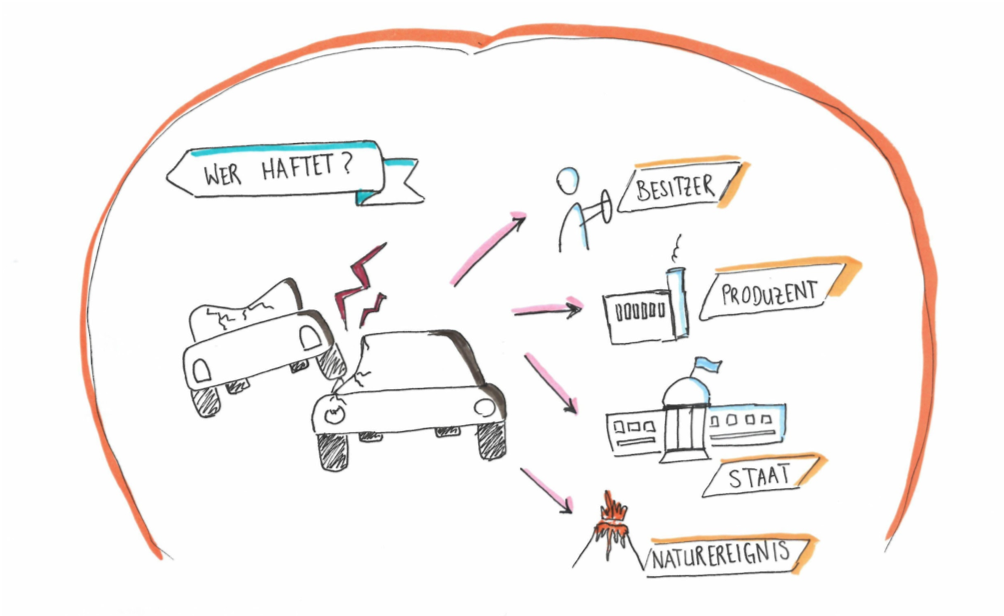

Haftungsmodelle: Wer trägt die Schuld?

Der schnelle technologische Fortschritt könnte Anpassungen der rechtlichen Grundlagen erfordern. Aktuell werden daher verschiedene Haftungsmodelle zu künstlicher Intelligenz diskutiert und verglichen. Ein mögliches Beispiel wäre, AI als Naturgewalt anzusehen. Für Prof. Dr. Oliver Bendel von der Fachhochschule Nordwestschweiz ist dies jedoch kein sinnvoller Lösungsansatz. Als Dozent für Maschinenethik hat er sich ausgiebig mit der Thematik um autonome Systeme (im Besonderen auch autonome Fahrzeuge) und den damit zusammenhängenden Herausforderungen beschäftigt. Würde ein Unfall dieser Art als Naturereignis eingestuft, so käme dies der Denkweise gleich, das gelegentliche Sterben von Menschen in solchen Situationen als normal zu erachten. Frei nach dem Motto “Es kann nicht beeinflusst werden und ab und zu wird es Opfer geben”.

Oliver Bendel stuft diese Vorstellung als zynisch ein. Speziell im Bereich des autonomen Fahrens sieht er eine mögliche Lösung des Problems darin, selbstfahrende Autos nur im dafür geeigneten Umfeld einzusetzen. Konkret schlägt er dafür vor allem die Autobahn vor, da gerade dort aufgrund der fehlenden Einflussfaktoren wie Fussgänger oder Fahrradfahrer das autonome Fahren viel sicherer gestaltet werden kann.

Ein weiterer Aspekt, der gegen die Naturereignis-Idee spricht, ist die Tatsache, dass autonome Systeme schliesslich Produkte von Entwicklern sind. Auch Dr. Philip C. Hanke, Verlagsleiter bei Weblaw und Experte für Rechts-, Volkswirtschafts- und Politikwissenschaft, ist dieser Meinung.

Er vertritt die Ansicht, dass mit zunehmender Autonomie von Systemen die Verantwortung der Hersteller wächst und diese daher in vernünftigem Mass für ihre entwickelten Systeme haften sollten. Die Auslagerung dieser Verantwortung, beispielsweise an eine speziell dafür geschaffene elektronische Persönlichkeit, schaffe am Ende mehr Probleme, als dass sie welche lösen würde. Aktuell wird der Hersteller eines Produkts für Design- oder Produktionsfehler belangt. Bei Unfällen, die sich bei der Verwendung des Produkts ereignen, haftet hingegen in der Regel der Konsument. Bei einem solchen Haftungsmodell würden sich Autobesitzer aber zu Recht fragen, warum sie überhaupt ein selbstfahrendes Auto kaufen sollten, wenn sie als Fahrzeuginsasse letzten Endes für jegliche Zwischenfälle die Verantwortung trügen.

Das Rechtssystem müsse hier korrekte Anreize schaffen, um diese Bedenken zu beseitigen. Ansonsten würden die Menschen in Zukunft gar nicht die Vorzüge des autonomen Fahrens geniessen können. Es mache wenig Sinn, dass der Insasse eines komplett autonomen Fahrzeugs, das über kein Lenkrad und keine Pedale verfügt, die Schuld an einem Unfall tragen soll. Dies wiederum würde auch seitens der Hersteller Bestrebungen verstärken, sicherere Systeme zu entwickeln. Schlussendlich sollte die Haftungsfrage aber immer berücksichtigen, wer zum Zeitpunkt eines Unfalls in der besten Position war, diesen zu verhindern. Gerade bei selbstfahrenden Autos spielt die Unterteilung in die Faktoren teilautonom und vollautonom eine wichtige Rolle. Beim erwähnten tödlichen Unfall von Tesla steuerte der Autopilot das Fahrzeug zum Zeitpunkt des Unfalls. Der Fahrer wäre jedoch jederzeit in der Lage gewesen, wieder die volle Kontrolle zu übernehmen.

“Die Aktionen von autonomen Systemen sind keine Naturereignisse, sie sind das pure Gegenteil.”

Prof. Dr. Oliver Bendel

Wie aus Internet-Videos hervorgeht, sind die Lenker eines solchen teilautonomen Fahrzeugs leider viel zu oft unvorsichtig (SRF, 2019). Nach Meinung von Oliver Bendel würden die Fahrer in solchen Situationen mitverantwortlich für ein Verkehrsunglück sein, da sie sich zu stark hätten ablenken lassen. Der Fahrzeughersteller hätte hier aus rechtlicher Sicht wohl keinen Fehler begangen. Prof. Dr. Bendel betont jedoch, dass hinsichtlich rechtlicher und ethischer Perspektiven unterschieden werden könne. Aus ethischer Sicht könne durchaus auch der Hersteller zur Verantwortung gezogen werden.

Denn Firmen wie Tesla oder Uber würden technisch noch nicht ausgereifte Autos auf den Markt bringen. Zuletzt sieht Prof. Dr. Oliver Bendel neben Lenker und Hersteller von autonomen Fahrzeugen einen Teil der Verantwortung auch beim Staat. Die Gesetze der USA beispielsweise seien zu locker und würden dadurch Unfälle dieser Art begünstigen.

Diskriminierung: Unfaire Entscheidungen von Algorithmen

Ein weiterer Aspekt, wie Menschen heute unter den Entscheidungen von künstlicher Intelligenz leiden können, ist die Diskriminierung. Computer sind fähig, riesige Mengen an Daten zu analysieren und darauf basierend Entscheidungen zu treffen. Diese Abläufe beinhalten immer eine gewisse Zweischneidigkeit. Einerseits ist es wünschenswert, dass ein Computer emotionslos und unvoreingenommen rein datenbasierte Entscheidungen trifft. Andererseits können so extrem harte und aus menschlicher Sicht nicht tragbare Konsequenzen entstehen. Ein gutes Beispiel dafür lieferte das Wall Street Journal im Artikel “Meet the new boss: Big Data” (Walker, 2012).

In diesem Bericht wird beschrieben, wie der Druckerhersteller Xerox die Daten der Call-Center-Mitarbeitenden mit einem massgeschneiderten Algorithmus analysiert hat. Zweck war es, herauszufinden, welche Eigenschaften Mitarbeitende haben müssen, um sie möglichst lange an die Firma zu binden. Anreiz für diese Analyse waren die relativ langen Trainingszeiten für neue Mitarbeitende und eine generell höhere Fluktuation in dieser Abteilung. Die Analyse hat ergeben, dass ein kurzer Arbeitsweg sowie eine tiefe Aktivität in sozialen Netzwerken entscheidend für die Anstellungsdauer sind. Basierend auf diesen Erkenntnissen wurde der Bewerbungsprozess bei Xerox für Call-Center-Mitarbeitende angepasst. Klassische Fragen bezüglich Arbeitserfahrung wurden durch jene mit computergenerierten Kriterien ersetzt. Dieses Vorgehen ist im Prinzip natürlich noch nicht diskriminierend. Es kann jedoch problematisch werden, wenn diese Kriterien von gewissen Bevölkerungsschichten nicht erfüllt werden können. Im Bericht des Jusletters (Daedelow, 2018) wird folgendes Beispiel verwendet, um die Problematik aufzuzeigen. Ein Bewerber ist auf der Suche nach einer längerfristigen Stelle und hat bereits Berufserfahrung in Call-Centern gesammelt. Er wird vom Computer jedoch als ungeeignet klassifiziert, weil sein Wohndomizil zu weit vom Arbeitsort entfernt ist. Der Wohnort des Bewerbers liegt in diesem Beispiel in einem Stadtbezirk mit einem hohen Ausländeranteil. Daedelow ist nun der Auffassung, das Auswahlkriterium “Wohnort nah am Arbeitsplatz” diskriminiere indirekt Bewerber ausländischer Herkunft, da diese von diesem Ablehnungskriterium überproportional betroffen sind.

Bestrafung von Robotern und die Zusammenarbeit mit diesen

Betrachten wir die Herausforderungen im Bereich des autonomen Fahrens und der Diskriminierung von Menschen durch AI, drängt sich das Gefühl auf, dass sich die Zusammenarbeit zwischen Mensch und Maschine in Zukunft schwierig gestalten wird. Zudem wird es vermutlich noch komplexer, sollten vermehrt auch humanoide Roboter zum Einsatz kommen. Laut Prof. Dr. Oliver Bendel neigen Menschen nämlich dazu, schnell eine Beziehung zu einem Roboter aufzubauen, ähnlich wie bei Tieren. Diese emotionale Bindung könnte bei Fehlfunktionen des Roboters das Verlangen hervorrufen, diesen zu bestrafen. Sowohl aus Expertensicht von Prof. Dr. Oliver Bendel und Dr. Philip C. Hanke sei es jedoch nicht sinnvoll, eine Art Gefängnisstrafe für Roboter oder allgemein künstliche Intelligenz vorzusehen. Dies bräuchte es in der Gegenwart und wohl auch in Zukunft nicht. Diesbezüglich sollten die Menschen nach Aussage von Prof.Dr. Oliver Bendel eher an sich selbst arbeiten, um sich nicht zu stark von Emotionen leiten zu lassen und so eine reibungslose Zusammenarbeit mit AI zu ermöglichen. Die Gefahr der emotionalen Falle schätze er nicht zu gross ein, da die meisten Menschen mit grosser Wahrscheinlichkeit nur gelegentlich mit Robotern zu tun haben werden. Vorsicht sei aber dort geboten, wo Personen ständig von Robotern umgeben sind. Insbesondere dort könnten sich gewisse Tendenzen von Menschen durch die ständige Präsenz von Robotern verstärken. Im schlimmsten Fall wäre dies eine Verstärkung persönlicher Probleme. Eine Möglichkeit, dem entgegenzuwirken, wäre die Einführung von sogenannten Verfremdungseffekten. Dadurch weist die künstliche Intelligenz den Menschen beispielsweise mit bewusst platzierten Aussagen darauf hin, dass sie nicht zu vermenschlichen sei. Tesla verfolgt bei ihrem Autopiloten einen ähnlichen Ansatz, obgleich es hier wohl zu weit ginge, von einem Verfremdungseffekt zu sprechen. Der Autopilot weist den Fahrer lediglich darauf hin, dass er weiterhin das Fahrzeug kontrollieren muss (Wolfangel, 2017). Prof. Dr. Bendel sieht hier aber die Problematik, dass sich Menschen an solche Hinweise gewöhnen und diese mit der Zeit gekonnt ignorieren könnten. Jedoch sei dieses Gebiet noch zu wenig erforscht und es wäre falsch, hier voreilige Schlüsse zu ziehen und gar Verbote für den Einsatz von autonomen Systemen und Robotern zu erlassen.

Rechtslage in der Schweiz: Sind wir schon soweit?

Der momentane Stand des Schweizer Rechts und verschiedene potentielle Ansätze zum Umgang mit der Schuldfrage bei Systemen künstlicher Intelligenz werden zurzeit umfassend in der juristischen Lehre diskutiert. Die Debatte reicht von Detailfragen bei bereits weit verbreiteten Technologien wie Roboter-Staubsaugern bis hin zu rein hypothetischen Science-Fiction-Terminator-Szenarien. Der rechtliche Rahmen beinhaltet jedoch zurzeit noch keine speziell auf autonome Systeme ausgelegte Inhalte, das heißt, es gibt noch keine spezifischen AI-Gesetze. Anpassungen, zum Beispiel des Produkthaftungsrechts, werden zwar diskutiert, aber es gibt noch keine konkreten Vorschläge dazu, wie der rechtliche Rahmen konkret verändert werden sollte. Es wird sich zeigen, wie die Gerichte die bestehenden Gesetze interpretieren und auslegen werden. Was an rechtlichen Anpassungen notwendig sein wird, werde daher von der künftigen Rechtsprechung abhängig sein, erklärt Dr. Philip C. Hanke. Bis jetzt gäbe es sehr wenige Urteile, in denen es um autonome Systeme ging. Erst wenn die ersten Urteile da sind, werde sich zeigen was mit den bestehenden Gesetzen und dem Ermessen der Richter gelöst werden könne, oder ob es gesetzliche Anpassungen brauche. Es sei noch zu früh zu sagen, welche Entwicklungen es geben würde. Bei vielen algorithmischen Verfahren sei es generell schwierig nachzuvollziehen, wie eine Entscheidung zustande gekommen ist. Man spricht daher auch oft von Blackbox-Algorithmen (Wolfangel, 2017). Dr. Hanke erklärt, dass dieses Verständnis für Unternehmen wichtig sein wird, wenn es darum geht, sich in einem Gerichtsverfahren zu verteidigen. Jedoch sei beispielsweise der Einsatz von neuronalen Netzwerken diesbezüglich nicht genau geregelt.

Möglicherweise werde es Übergangsregelungen für AI geben, wie früher bei der Einführung des Autos. Damals mussten Autos speziell gekennzeichnet werden und es musste sichergestellt werden, dass Autos die Pferde nicht erschreckten. Als das Auto dann verbreiteter war und es weniger Pferde gab, haben sich diese Regeln erübrigt.

Den eingangs erähnten Uber-Fall schätzt Dr. Philip C. Hanke dahingehend ein, dass in der Schweiz vermutlich ähnlich entschieden worden wäre. Da noch eine Fahrerin im Auto war, die noch hätte eingreifen können, sei es durchaus sinnvoll, eine gewisse Haftung bei dieser Person zu belassen. Schliesslich sei sie in der besten Position, um einen Unfall vermeiden zu können. Auch international findet momentan ein globaler Denkprozess statt. Man fragt sich, ob und wie AI umfasend reguliert werden soll. Philip C. Hanke plädiert für globale Lösungen und den internationalen Austausch.

Es sei wichtig, dass es keine Insellösungen gäbe. Die Schweiz werde nicht in der Lage sein, eine ganz individuelle Regelung einzuführen. Die Kompatibilität zwischen den Ländern müsse gegeben sein, denn selbstfahrende Autos sollten nicht nur in einem einzigen Land fahren können.

Wessen Regeln zählen?

Eine weitere Herausforderung bei der Einführung neuer Technologien ist jeweils deren Akzeptanz und Verbreitung in der Bevölkerung. Während die intelligenten Algorithmen und zunehmend automatisierten Fahrzeuge langsam mehr und mehr in unseren Alltag drängen, stellt sich die Frage, wessen Moral und Regeln sie letztendlich befolgen. Programmierer bringen den Maschinen bei, wie sie sich zu verhalten haben, aber nach welchen und wessen Regeln sollen sie funktionieren?

Eine einfache Handlung wie das Winken vor dem Zebrastreifen bedeute in Deutschland „Fahr weiter“, während die gleiche Geste in der Schweiz jedoch “Anhalten” bedeute. Mit diesem Beispiel zeigt Oliver Bendel auf, wie komplex der Einsatz von Künstlicher Intelligenz im Strassenverkehr ist. Jedes Fahrzeug müsste alle kulturellen und gesetzlichen Unterschiede kennen und sich je nach Land an verschiedene Verhaltensweisen und Gesetze anpassen können. Da das Fahrzeug den momentanen Standort ermitteln könne, könnten die länderspezifischen Regeln nach dieser Information umgesetzt werden. Es bräuchte eine internationale und unabhängige Möglichkeit, den Strassenverkehr zu autonomisieren. Wenn es soweit kommen würde, dass globale Standards eingesetzt würden, müssten lokale wie auch individuelle Befindlichkeiten berücksichtigt werden, was wiederum hoch komplex sein würde. Mit diesen Argumenten erklärt sich Oliver Bendel zum autonomen Fahren insgesamt als sehr skeptisch.

Im Zusammenhang mit Herausforderungen durch AI und Robotik geben die drei Robotergesetze Asimovs (1942) eine umfassende Idee, was hierbei als relevant erachtet werden sollte. Für Maschinen- und Roboterethiker Oliver Bendel sind diese zwar eine Inspiration, tatsächlich funktionierten sie in diesem Umfang nach seiner Meinung aber nur in der Geschichte und kämen selbst da an ihre Grenzen. Alleine an der Anzahl der Gesetze könne erkannt werden, dass sie nicht ausreichend seien. Als Maschinenethiker baut Prof. Dr. Oliver Bendel mit seinem Team Chatbots, denen sie mit Hilfe von Metaregeln und Regeln eine gewisse Moral einpflanzen. Er forscht an sogenannten Moralmenüs, die eine Stellvertretermaschine mit einer Stellvertretermoral erzeugen. Auf das Beispiel von autonomen Fahrzeugen übertragen, würde das heissen, dass Besitzer ihre Autos so programmieren könnten, dass diese eine aggressive Fahrweise aufweisen oder nur auf die Sicherheit des Fahrers sensibilisiert würden.

Dies würde Oliver Bendel jedoch ablehnen – Moralmenüs eigneten sich nur bedingt für die offene Welt und den öffentlichen Raum.

Wird AI zur Pflicht? Conclusio und Ausblick

Die Verbreitung von AI bringt verschiedene ethische und rechtliche Herausforderungen mit sich. Anpassungen des rechtlichen Rahmens werden sowohl in der Schweiz als auch international intensiv diskutiert, jedoch gibt es noch keine konkreten Vorschläge, wie dieser rechtliche Rahmen verändert werden sollte. Erst die künftige Rechtsprechung wird zeigen, ob die momentane Gesetzgebung ausreicht, um Rechtsstreitigkeiten bezüglich AI zu lösen. Sollte dieser Zustand als Unsicherheit ausgelegt werden, könnte die Entwicklung und Einführung neuer Technologien gehemmt werden. Bei den Haftungsmodellen sind die elektronische Person sowie die Betrachtung als Naturereignis nicht zielführend. Ein Haftungsmodell mit Verantwortung beim Nutzer und Hersteller, bei welchem sich die Verantwortung mit zunehmendem Grad der Automatisierung zum Hersteller verschiebt, erscheint sinnvoller.

Es ist vorstellbar, dass in der Zukunft Verpflichtungen entstehen, Daten zu teilen.

Dr. Philip C. Hanke

Neben der Frage, welche rechtlichen und ethischen Herausforderungen die Verbreitung von künstlicher Intelligenz mit sich bringt, verdient auch die Umkehrfrage entsprechende Aufmerksamkeit: Was passiert, wenn künstliche Intelligenz nicht eingesetzt wird?

Über 90 Prozent aller Unfälle im Strassenverkehr sind auf Fehlverhalten oder Fehleinschätzungen der lenkenden Person zurückzuführen (BFU, 2019). Im Gegensatz zum Menschen wird künstliche Intelligenz nicht müde oder damit fehleranfälliger, weil sie länger arbeitet. Dr. Philip C Hanke erklärt, dass wir uns als Gesellschaft die Frage stellen müssten, ob es nicht bald sogar zu Verpflichtungen kommen würde, künstliche Intelligenz einzusetzen:

“Meine Vorhersage ist, dass es in ein paar Jahrzehnten verboten sein wird, ein Auto selbst zu fahren, weil es als zu gefährlich eingestuft werden wird. So wie es heute verboten ist, ohne Sicherheitsgurte oder ohne Scheinwerfer zu fahren, wird es in der Zukunft verboten sein, ohne Autopiloten zu fahren.”

Zum Thema Datenschutz fügt er ausserdem hinzu:

“Personen haben ein legitimes Interesse, dass persönliche Daten nicht eingesehen werden. Aber was, wenn diese Daten die Systeme viel besser machen? Entsteht daraus eine zumindest moralische Verpflichtung die Daten zu teilen, weil dies das Leben von anderen retten könnte? Es ist vorstellbar, dass in der Zukunft Verpflichtungen entstehen, Daten zu teilen.”

Möglich sei also auch, dass trotz momentan noch offenen ethischen und rechtlichen Fragen der Einsatz von AI zur Pflicht würde und wir mit unseren Daten dazu beitragen, die Systeme zu verbessern. Die oben erwähnten Unfallzahlen würden zeigen, ob sich der Einsatz lohnt.

Quellen

Bendel, O. (2019). Künstliche Intelligenz und deren rechtliche und ethische Herausforderungen. Interview, Brugg, 21.03.2019.

BFU (2019). Fahrassistenzsysteme – selbstfahrende Autos. Abgerufen am 5. Mai 2019 von https://www.bfu.ch/de/ratgeber/ratgeber-unfallverh%C3%BCtung/strassenverkehr/autofahrer/fahrerassistenz-systeme/fahrerassistenz-systeme

Daedelow R. (2018). Jusletter. Wenn Algorithmen (unfair) über Menschen entscheiden

Hanke, P. C. (2019). Künstliche Intelligenz und deren rechtliche Herausforderungen. Interview, Bern, 25.04.2019.

Hebermehl, G., Stegmaier, G. (2018). Sicherheitsfahrerin streamte Fernsehprogramm | auto-motor-und-sport.de. Abgerufen am 9. Mai 2019 von https://www.auto-motor-und-sport.de/news/toedlicher-unfall-autonom-fahrendes-auto-uber-volvo-video/

Henkel, C. H. (2016). Wenn der «Roboter am Lenkrad» einen Fehler macht | NZZ. Abgerufen 4. Mai 2019, von https://www.nzz.ch/wirtschaft/unternehmen/haftungsfrage-nach-toedlichem-tesla-unfall-wenn-der-roboter-am-lenkrad-einen-fehler-macht-ld.103508

SRF (2019). Tödlicher Unfall mit Tesla ruft Behörden auf den Plan. Abgerufen am 4. Mai 2019 von https://www.srf.ch/news/international/aehnlichkeit-mit-crash-2016-toedlicher-unfall-mit-tesla-ruft-behoerden-auf-den-plan

Walker, J. (2012). Walll Street Journal. Meet the new Boss: Big Data – Companies Trade in Huch-Based Hiring for Computer Modeling. Abgerufen am 29. April 2019 von https://www.wsj.com/articles/SB10000872396390443890304578006252019616768

Wolfangel, E. (2017). Künstliche Intelligenz voller Vorurteile | NZZ. Abgerufen 5. Mai 2019, von https://www.nzz.ch/wissenschaft/selbstlernende-algorithmen-kuenstliche-intelligenz-voller-vorurteile-ld.1313680

Autoren

Ayse Yildiz, Silvan Burnand, Luis Limonta, Patrick Sommer & Lars Gisler

Contact us if you have any questions about the degree programme or for individual advice:

Tel.: +41 41 228 42 53 / E-mail: master.ids@hslu.ch

Data is the resource of the 21st century!

Register and join us for a free online Information-Event:

Monday, 11 August 2025 (Online, English)

Monday, 8 September 2025 (Online, German)

Monday, 6 October 2025 (Online, English)

Monday, 3 November 2025 (Online, German)

MORE INFORMATION TO THE MASTER’S PROGRAMME HERE:

MORE FIELD REPORTS & EXPERIENCES: Professional portraits & study insights

PROGRAMME INFO: MSc in Applied Information and Data Science

CHECK OUT OUR: Generalist profile

FREQUENTLY ASKED QUESTIONS: FAQ